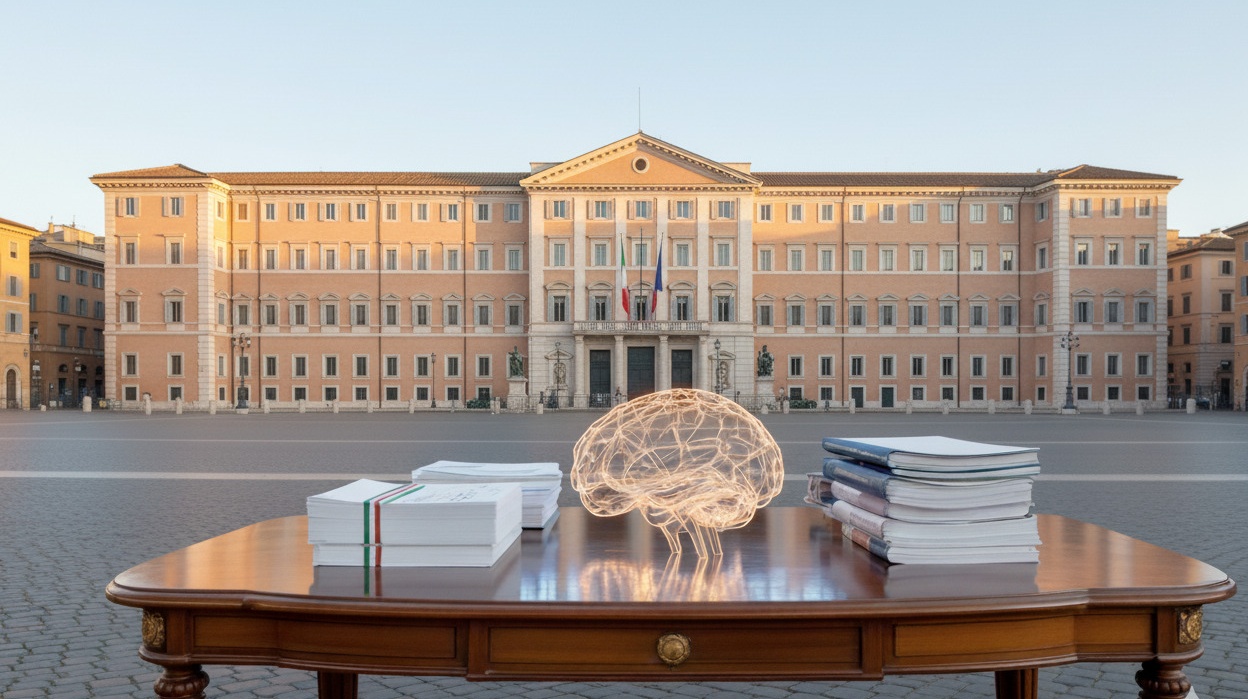

Il 17 settembre 2025, il parlamento italiano ha approvato una legge sull’intelligenza artificiale, diventando il primo Stato membro dell’UE a implementare una normativa nazionale in linea con l’AI Act europeo. L’approvazione del testo finale ha concluso un processo legislativo iniziato quando il DDL è stato presentato a Maggio 2024. L’approccio normativo “incentrato sull’uomo” dell’Italia stabilisce un precedente significativo per la governance europea dell’IA, enfatizzando trasparenza, democrazia e supervisione umana.

La legislazione italiana adotta un sistema normativo che dà priorità all’agenzia umana nei processi decisionali. L’approccio incentrato sull’uomo dell’Italia si distingue da strategie normative puramente tecniche o orientate al mercato e ha il potenziale di influenzare le legislazioni degli altri Stati membri dell’UE. Questo quadro posiziona l’Italia all’avanguardia del dibattito europeo e globale sulla governance dell’IA. Di seguito, riassumiamo i punti principali della legislazione ed evidenziamo quelli che pensiamo siano i punti critici.

Disposizioni chiave

La legislazione stabilisce una serie di principi generali che si costruiscono in linea con quelli definiti dalle istituzioni europee, introducendo regole nei settori sanitario, del lavoro, della pubblica amministrazione, della giustizia, dell’istruzione e dello sport. La legge stabilisce che tutte le applicazioni all’interno di questi domini devono mantenere la tracciabilità delle decisioni intorno al sistema e incorporare la supervisione umana nel processo decisionale, ma senza offrire dettagli sulla implementazione in ogni settore.

La legge introduce sanzioni penali per i deepfake e contenuti generati dall’IA non autorizzati. I genitori dovranno fornire consenso esplicito per l’uso di sistemi di IA da parte di bambini sotto i 14 anni, mentre nuove disposizioni sul copyright chiariscono le regole di proprietà intellettuale per le opere creative assistite dall’IA. Le attività di text e data mining sono limitate a contenuti autorizzati o non protetti da copyright, bilanciando innovazione e protezione della proprietà intellettuale.

Governance e implementazione

Le responsabilità di supervisione primaria spettano all’Agenzia per l’Italia Digitale (AGID) e all’Agenzia per la Cybersicurezza Nazionale (ACN), che coordineranno la governance nazionale dell’IA. Le autorità regolatorie di settore—inclusi la Banca d’Italia, la Consob e l’Agcom—mantengono la propria competenza all’interno dei rispettivi domini, creando un sistema normativo distribuito ma coordinato.

Inoltre la legge prevede fino a un miliardo di euro in finanziamenti di capitale di rischio attraverso la Cassa Depositi e Prestiti per sostenere l’innovazione nell’IA; questo passaggio è stato presentato dal Governo come una dimostrazione dell’impegno dell’Italia nel bilanciare regolamentazione e progresso tecnologico.

Allineamento UE e implicazioni per l’accesso al mercato

La legislazione italiana ha implicazioni significative per l’accesso al mercato italiano. La legge si allinea esplicitamente con le definizioni e principi dell’AI Act dell’UE stabilendo al contempo obblighi aggiuntivi a livello nazionale. Ciò comporta sfide di compliance stratificate, in quanto le aziende dovranno navigare contemporaneamente sia i requisiti dell’UE che quelli specifici italiani per operare nel paese.

Tuttavia, l’esclusione dei requisiti di localizzazione dei dati dalla legislazione finale, che era stata vociferata durante la discussione della legge, rimuove una barriera significativa ai flussi di dati transfrontalieri. Rimangono preoccupazioni riguardo ai criteri preferenziali negli appalti pubblici che potrebbero svantaggiare i concorrenti stranieri.

Sfide e aree di miglioramento

Governance

Esiste un rischio di coordinazione tra le istituzioni pubbliche coinvolte nel sistema proposto, come AgID, ACN, ed i regolatori settoriali: la struttura multi-regolatore introduce complessità che potrebbero ostacolare l’applicazione coordinata e creare problemi di certezza del diritto.

Implementazione

Sono carenti dei meccanismi chiari di opt-out per l’uso dei dati sanitari e limitate le tutele per la proprietà intellettuale. Oltre a ciò i critici sostengono che l’allocazione di un miliardo di euro di finanziamento rimane insufficiente per un sostegno significativo allo sviluppo dell’IA rispetto ai bisogni finanziari del settore, generando dubbi sulle ambizioni di innovazione del Governo.

Chiarezza

Sebbene la legge faccia riferimento alle definizioni dell’EU AI Act nell’Articolo 2, il resto della legge utilizza spesso termini differenti in riferimento a processi decisionali automatizzati o sistemi ad alto rischio, creando rischi di interpretazioni contrastanti. Questa ambiguità può complicare gli sforzi di compliance e minare l’uniformità dell’applicazione.

Sfide Future e Requisiti di Monitoraggio

La sfida più grande, nel caso di una tecnologia ad evoluzione veloce come l’IA, è evitare che le norme diventino rapidamente obsolete. Per questo motivo, per essere efficace la legislazione dovrà sviluppare ed implementare meccanismi di monitoraggio attivo e aggiornamento continuo. La specificazione di criteri di certificazione tecnica, sistemi di audit, disposizioni di responsabilità civile e obblighi assicurativi, sono elementi che impattano direttamente sulla implementazione della legge.

CePTE sosterrà l’implementazione tramite opinioni e consigli continui mentre le tecnologie e le loro implicazioni continuano a evolversi. Infatti, riteniamo che l’approccio pionieristico dell’Italia, che bilancia promozione dell’innovazione e considerazioni etiche, costituisca un modello che, se implementato con successo, influenzerà significativamente sia lo sviluppo normativo europeo che gli standard globali di governance.